еӨҡдјҰеӨҡеӨ§еӯҰејҖеҸ‘еҸҚдәәи„ёиҜҶеҲ«зі»з»ҹ иҜҶеҲ«жҲҗеҠҹзҺҮйҷҚиҮі 0.5%

гҖҖгҖҖвҖңеҲ·и„ёвҖқпјҢдҪңдёәдёҖз§ҚдёӘдәәиә«д»ҪйүҙеҲ«жҠҖжңҜпјҢеңЁж·ұеәҰеӯҰд№ зӯүжҠҖжңҜзҡ„жҠӨжҢҒдёӢзІҫеәҰеҫ—д»ҘеӨ§е№…жҸҗеҚҮпјҢеңЁLFWдёҠпјҢеҗ„еӨ§зҺ©е®¶еңЁж— йҷҗеҲ¶жқЎд»¶дёӢдәәи„ёйӘҢиҜҒжөӢиҜ•пјҲunrestricted labeled outside dataпјүдёӯжҸҗдәӨзҡ„жҲҗз»©жҷ®йҒҚиғҪеӨҹиҫҫеҲ°99.5%д»ҘдёҠгҖӮ

гҖҖгҖҖдәәи„ёиҜҶеҲ«жҠҖжңҜж—ҘзӣҠжҲҗзҶҹзҡ„иғҢеҗҺпјҢдҪңдёәиҮӘеёҰAIиҗҪең°еҹәеӣ зҡ„е®үйҳІиЎҢдёҡпјҲж•°жҚ®еӨ§гҖҒй«ҳиҜ•й”ҷе®№еҝҚеәҰпјүпјҢиҝҷеҮ е№ҙпјҢеӨ©зҪ‘е·ҘзЁӢе№ҝжіӣй“әејҖгҖҒжҷәиғҪзі»з»ҹе…ЁеұҖеә”з”ЁпјҢеҹҺеёӮ秩еәҸеҫ—еҲ°дәҶжӣҙдёәй«ҳж•Ҳзҡ„з®ЎзҗҶе’ҢйҳІжҠӨпјҢж°‘з”ҹйңҖжұӮеҫ—еҲ°дәҶжӣҙдёәеҸҠж—¶зҡ„еӨ„зҗҶе’ҢеҸҚйҰҲпјҢиҝқеҸҚд№ұзәӘзҡ„иЎҢдёәиғҪиў«зІҫеҮҶиҜҶеҲ«е’ҢеӨ„зҪҡгҖӮ

гҖҖгҖҖдёҺжӯӨеҗҢж—¶пјҢдәәи„ёиҜҶеҲ«зі»з»ҹзҡ„еә”з”Ёд№ҹйўҮеҸ—дәүи®®гҖӮ

гҖҖгҖҖеңЁеӨ§жҙӢеҪјеІёзҡ„зҫҺеӣҪпјҢдәҡ马йҖҠеӣ еҗ‘зҫҺеӣҪжү§жі•жңәжһ„жҸҗдҫӣдәәи„ёиҜҶеҲ«жҠҖжңҜиҖҢйҒӯеҲ°жҹҗиҒ”зӣҹзҡ„и°ҙиҙЈгҖӮиҜҘиҒ”зӣҹиЎЁзӨәпјҢвҖңдәҡ马йҖҠд»ҘеҚҒеҲҶдҪҺе»үзҡ„д»·ж јеҗ‘зҫҺеӣҪиӯҰж–№жҸҗдҫӣдәәи„ёиҜҶеҲ«жңҚеҠЎпјҢеҸҜиғҪдјҡеҜјиҮҙзҫҺеӣҪе…¬ж°‘зҡ„з§Ғдәәж•°жҚ®иў«ж»Ҙз”ЁеҸҠйҡҗз§ҒйҒӯеҲ°дҫөзҠҜвҖқгҖӮ

гҖҖгҖҖеңЁд»–们зңӢжқҘпјҢе°Ҷдәәи„ёиҜҶеҲ«жҠҖжңҜеә”з”ЁеҲ°еүҚз«Ҝи§Ҷйў‘зӣ‘жҺ§ж‘„еғҸжңәдёҠпјҢеҸҜиғҪдјҡжү“з ҙйҡҗз§ҒеҸҠе®һз”ЁжҖ§д№Ӣй—ҙзҡ„е№іиЎЎгҖӮеҒҮи®ҫзҫҺеӣҪиӯҰж–№жңүиӢҘе№ІеҸ°иҝҷж ·зҡ„е®үйҳІж‘„еғҸжңәпјҢеҗҢж—¶жӢҘжңүеҸҜз–‘дәәе‘ҳзҡ„вҖңй»‘еҗҚеҚ•вҖқз…§зүҮеә“пјҢйӮЈд№Ҳе…¶д»–д»»дҪ•дәәеҰӮжһңдёҺиҝҷдәӣеҸҜз–‘дәәе‘ҳжңүдёҖдәӣзӣёеғҸпјҢдёҖж—Ұиҝӣе…ҘиӯҰеҜҹзҡ„е®үйҳІж‘„еғҸжңәзҡ„й•ңеӨҙд№ӢеҶ…пјҢйғҪжңүеҸҜиғҪеҸ—еҲ°иӯҰеҠЎдәәе‘ҳзҡ„зӣҳй—®гҖӮиҖҢеӨ§еӨҡж•°зҫҺеӣҪдәәдёҚеёҢжңӣз”ҹжҙ»еңЁйӮЈж ·зҡ„дё–з•ҢйҮҢгҖӮ

гҖҖгҖҖд»ҺиҝҷжқҘзңӢпјҢжҠҖжңҜеә”з”Ёзҡ„еҸҢеҲғеү‘еңЁдәәи„ёиҜҶеҲ«зҡ„иҗҪең°дёҠе°ұеҫ—д»ҘдҪ“зҺ°пјҢдё”дёҚиҜҙдәәи„ёиҜҶеҲ«жҠҖжңҜеҸ‘еұ•еҜ№дәҺдәәзұ»жқҘиҜҙдјҳеӨҡпјҲе®үе…ЁпјүиҝҳжҳҜеҠЈеӨҡпјҲйҡҗз§ҒпјүпјҢзЎ¬еёҒжҠӣдёӢиҗҪең°зҡ„еҸҜиғҪжҖ§иҝҳжҳҜеҫ—еҲ°дәҶе№іиЎЎгҖӮ

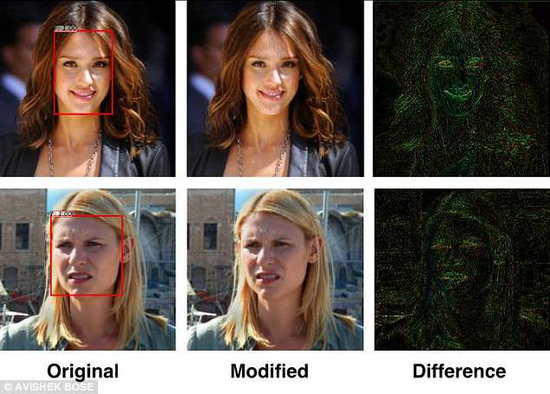

гҖҖгҖҖиҝ‘ж—ҘпјҢеӨҡдјҰеӨҡеӨ§еӯҰж•ҷжҺҲParham Aarabiе’Ңд»–зҡ„з ”з©¶з”ҹAvishek BoseејҖеҸ‘дәҶдёҖз§Қз®—жі•пјҢйҖҡиҝҮеҜ№еӣҫеғҸиҝӣиЎҢвҖңе…үиҪ¬жҚўвҖқпјҢеҸҜд»ҘеҠЁжҖҒең°з ҙеқҸдәәи„ёиҜҶеҲ«зі»з»ҹгҖӮ

гҖҖгҖҖдёҺдёҠиҝ°иҒ”зӣҹжҺ§иҜүдәҡ马йҖҠзҡ„зҗҶз”ұдёҖж ·пјҢиҝҷдҪҚеӨ§еӯҰж•ҷжҺҲд№ҹиҖғиҷ‘еҲ°дәҶйҡҗз§Ғй—®йўҳпјҢвҖңйҡҸзқҖдәәи„ёиҜҶеҲ«жҠҖжңҜи¶ҠжқҘи¶Ҡе…ҲиҝӣпјҢдёӘдәәйҡҗз§ҒжҲҗдёәдәҶдёҖдёӘзңҹжӯЈжҖҘйңҖи§ЈеҶізҡ„й—®йўҳпјҢиҝҷе°ұжҳҜеҸҚдәәи„ёиҜҶеҲ«зі»з»ҹиў«з ”еҸ‘зҡ„еҺҹеӣ пјҢд№ҹжҳҜиҜҘзі»з»ҹзҡ„з”ЁжӯҰд№Ӣең°гҖӮвҖқ

гҖҖгҖҖж №жҚ®Aarabiзҡ„иҜҙжі•пјҢ他们主иҰҒйҮҮз”ЁдәҶеҜ№жҠ—и®ӯз»ғпјҲadversarial trainingпјүжҠҖжңҜпјҢдҪҝеҫ—дёӨдёӘзҘһз»ҸзҪ‘з»ңзӣёдә’еҜ№жҠ—пјҢдёҖдёӘзҘһз»ҸзҪ‘з»ңд»Һж•°жҚ®дёӯиҺ·еҸ–дҝЎжҒҜпјҲдәәи„ёж•°жҚ®пјүпјҢеҸҰдёҖдёӘзҘһз»ҸзҪ‘з»ңиҜ•еӣҫеҺ»з ҙеқҸ第дёҖдёӘзҘһз»ҸзҪ‘з»ңжү§иЎҢзҡ„д»»еҠЎгҖӮ

гҖҖгҖҖжҚ®жӮүпјҢ他们зҡ„з®—жі•жҳҜеңЁеҢ…еҗ«дёҚеҗҢз§Қж—ҸпјҢдёҚеҗҢе…үз…§жқЎд»¶е’ҢиғҢжҷҜзҺҜеўғдёӢзҡ„и¶…иҝҮ600еј дәәи„ёз…§зүҮзҡ„ж•°жҚ®йӣҶдёҠиҝӣиЎҢи®ӯз»ғзҡ„пјҲдёҡз•Ңж ҮеҮҶеә“пјүпјҢдёӨдёӘзҘһз»ҸзҪ‘з»ңзӣёдә’еҜ№жҠ—дјҡеҸ‘еҪўжҲҗдёҖдёӘе®һж—¶зҡ„вҖңиҝҮж»ӨеҷЁвҖқпјҢе®ғеҸҜд»Ҙеә”з”ЁеҲ°д»»дҪ•еӣҫзүҮдёҠгҖӮеӣ дёәе®ғзҡ„зӣ®ж ҮвҖ”вҖ”еӣҫеғҸдёӯзҡ„еҚ•дёӘеғҸзҙ жҳҜзү№е®ҡзҡ„пјҢж”№еҸҳдёҖдәӣзү№е®ҡеғҸзҙ пјҢиӮүзңјжҳҜеҮ д№Һж— жі•еҜҹи§үзҡ„гҖӮжҜ”еҰӮиҜҙжЈҖжөӢзҪ‘з»ңжӯЈеңЁеҜ»жүҫзңји§’пјҢе№Іжү°з®—жі•е°ұдјҡи°ғж•ҙзңји§’пјҢдҪҝеҫ—зңји§’зҡ„еғҸзҙ дёҚйӮЈд№ҲжҳҫзңјгҖӮз®—жі•еңЁз…§зүҮдёӯйҖ жҲҗдәҶйқһеёёеҫ®е°Ҹзҡ„е№Іжү°пјҢдҪҶеҜ№дәҺжЈҖжөӢеҷЁжқҘиҜҙпјҢиҝҷдәӣе№Іжү°и¶ід»Ҙж¬әйӘ—зі»з»ҹгҖӮ

гҖҖгҖҖвҖңжӯӨеүҚеӨҡе№ҙпјҢиҝҷдәӣз®—жі•еҝ…йЎ»з”ұдәәзұ»еҺ»е®ҡд№үпјҢзҺ°еңЁзҡ„зҘһз»ҸзҪ‘з»ңеҸҜд»ҘиҮӘдё»еӯҰд№ гҖӮзӣ®еүҚжҲ‘们зҡ„з®—жі•е°Ҷдәәи„ёиҜҶеҲ«зі»з»ҹдёӯиў«жЈҖжөӢеҲ°зҡ„дәәи„ёзҡ„жҜ”дҫӢйҷҚдҪҺеҲ°дәҶ0.5%гҖӮжҲ‘们еёҢжңӣеңЁAPPжҲ–зҪ‘з«ҷдёҠжҸҗдҫӣиҝҷз§ҚзҘһз»ҸзҪ‘з»ңзі»з»ҹпјҢиҝҷжҳҜдёҖдёӘйқһеёёжңүж„ҸжҖқзҡ„йўҶеҹҹпјҢжңүзқҖйқһеёёеӨ§зҡ„жҪңеҠӣеёӮеңәпјҢвҖқAarabiж•ҷжҺҲиҜҙйҒ“пјҢвҖңеҸҰеӨ–з ”з©¶жҠҘе‘Ҡд№ҹе°ҶеңЁ2018е№ҙIEEEеӣҪйҷ…еӨҡеӘ’дҪ“дҝЎеҸ·еӨ„зҗҶз ”и®ЁдјҡдёҠеҸ‘иЎЁвҖқгҖӮ

гҖҖгҖҖе…¶е®һпјҢз ҙеқҸдәәи„ёиҜҶеҲ«дә§е“ҒиҜҶеҲ«зҺҮзҡ„дә§е“Ғ并дёҚе°‘и§ҒгҖӮж—©еңЁ2016е№ҙпјҢеҚЎеҶ…еҹәжў…йҡҶеӨ§еӯҰзҡ„з ”з©¶дәәе‘ҳе°ұи®ҫи®ЎдәҶдёҖз§Қзңјй•ңжЎҶпјҢеҸҜд»ҘиҜҜеҜјйқўйғЁиҜҶеҲ«зі»з»ҹпјҢдҪҝе…¶дә§з”ҹй”ҷиҜҜзҡ„иҜҶеҲ«гҖӮ

гҖҖгҖҖиҜҘзұ»иҪҜ件еңЁеӯҰд№ дәәи„ёзҡ„жЁЎж ·ж—¶пјҢе®ғйқһеёёдҫқйқ дәҺзү№е®ҡзҡ„з»ҶиҠӮпјҢеҰӮйј»еӯҗе’ҢзңүжҜӣзҡ„еҪўзҠ¶гҖӮеҚЎеҶ…еҹәжў…йҡҶеӨ§еӯҰжү“йҖ зҡ„зңјй•ң并дёҚеҸӘжҳҜиҰҶзӣ–йӮЈдәӣи„ёйғЁз»ҶиҠӮпјҢиҝҳдјҡеҚ°дёҠиў«и®Ўз®—жңәи®ӨдёәжҳҜдәәи„ёз»ҶиҠӮзҡ„еӣҫжЎҲгҖӮйӣ·й”ӢзҪ‘йӣ·й”ӢзҪ‘

гҖҖгҖҖжқҘиҮӘVentureBeatпјҢйӣ·й”ӢзҪ‘(е…¬дј—еҸ·пјҡйӣ·й”ӢзҪ‘)зј–иҜ‘

гҖҖгҖҖйӣ·й”ӢзҪ‘еҺҹеҲӣж–Үз« пјҢжңӘз»ҸжҺҲжқғзҰҒжӯўиҪ¬иҪҪгҖӮиҜҰжғ…и§ҒиҪ¬иҪҪйЎ»зҹҘгҖӮ

еҸ‘иЎЁиҜ„и®ә